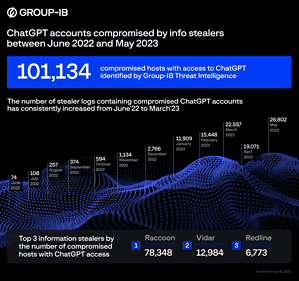

Innerhalb eines Jahres wurden über 100.000 ChatGPT-Konten gehackt und auf Dark-Web-Marktplätzen verkauft. Das gibt Cyberkriminellen die Möglichkeit die KI für ihre Zwecke zu nutzen und gleichzeitig die im Chat-Verlauf gespeicherten Daten zu stehlen – teils sehr sensible Unternehmensgeheimnisse.

Die Experten von Group-IB haben 101.134 mit Info-Stealern infizierte Geräte mit gespeicherten ChatGPT-Anmeldeinformationen identifiziert. Die Threat-Intelligence- Plattform von Group-IB hat diese kompromittierten Zugangsdaten in den Protokollen von Malware zum Informationsdiebstahl gefunden, die im vergangenen Jahr auf illegalen Dark-Web-Marktplätzen gehandelt wurde. Die Anzahl der verfügbaren Protokolle mit kompromittierten ChatGPT-Konten erreichte im Mai 2023 einen Höchststand mit über 26.800.

ChatGPT: Reger Handel mit Zugangsdaten

🔎 Allein Group-IB hat innerhalb eines Jahres über 100.000 gestohlene ChatGPT-Zugangsdaten registriert die danach im Darknet zu angeboten wurden (Bild: Group-IB).

Die Experten von Group-IB betonen, dass immer mehr Mitarbeiter den Chatbot nutzen, um ihre Arbeit zu optimieren, sei es in der Softwareentwicklung oder in der Geschäftskommunikation. Standardmäßig speichert ChatGPT den Verlauf von Benutzeranfragen und KI-Antworten. Folglich können durch unbefugten Zugriff auf ChatGPT-Konten vertrauliche oder sensible Informationen offengelegt werden, die für gezielte Angriffe auf Unternehmen und deren Mitarbeiter ausgenutzt werden können. Den neuesten Erkenntnissen von Group-IB zufolge erfreuen sich ChatGPT-Konten in Untergrundgemeinschaften bereits großer Beliebtheit.

Die Threat-Intelligence-Plattform von Group-IB speichert die branchenweit größte Bibliothek an Dark-Web-Daten, überwacht Foren, Marktplätze und geschlossene Communities von Cyberkriminellen in Echtzeit, um kompromittierte Zugangsdaten, gestohlene Kreditkarten, neue Malware-Beispiele, Zugriffe auf Unternehmensnetzwerke und andere wichtige Informationen zu identifizieren.

Kommentar von ESET-Spezialist

„Vielen Nutzerinnen und Nutzern von ChatGPT sind sich nicht bewusst, dass ihre Konten eine große Menge an sensiblen Informationen enthalten und für Cyberkriminelle sehr interessant sind. Alle Eingabeaufforderungen werden standardmäßig gespeichert. Je mehr Informationen Chatbots erhalten, desto attraktiver werden sie für Hacker. Es ist daher ratsam, sich genau zu überlegen, welche Informationen sie in cloudbasierte Chatbots und andere Dienste eingeben. Diese vertraulichen Daten können für gezielte Angriffe auf Unternehmen und deren Mitarbeiter genutzt werden.

Darüber hinaus werden sogenannte Info-Stealer immer häufiger bei ChatGPT-Angriffen und sogar bei Malware-as-a-Service-Angriffen eingesetzt. Info-Stealer konzentrieren sich auf den Diebstahl vertraulicher Daten, die auf einem kompromittierten System gespeichert sind. Sie suchen nach wichtigen Informationen wie Kryptowährungs-Wallet-Datensätzen, Zugangsdaten und Passwörtern sowie gespeicherten Browser-Logins.

Die Tatsache, dass ein normaler Nutzer mit kostenlosem Zugang keine Möglichkeit hat, die Zwei-Faktor- bzw. Multi-Faktor-Authentifizierung zu aktivieren, macht den Dienst äußerst angreifbar. Es wird daher empfohlen, die Chat-Speicherfunktion zu deaktivieren, wenn sie nicht unbedingt notwendig ist. Darüber hinaus raten wir zur Nutzung einer Single-Sign-On-Option, die ebenfalls 2FA verwendet.“ so Jake Moore, Global Security Advisor bei ESET.

Mehr bei Group-IB.com